Co zamiast ChatGPT? Najciekawsze modele AI w praktyce

Modele generatywne przestały tworzyć jedną kategorię narzędzi. ChatGPT otworzył drogę do pracy z AI, lecz kolejne miesiące pokazały, że różne zadania wymagają różnych rozwiązań. Pojawiły się systemy o ogromnych kontekstach, wyszukiwarki AI pracujące na bieżących danych, platformy pozwalające przełączać modele jednym kliknięciem oraz otwarte modele wdrażane na własnych serwerach. Wraz z nimi zmienia się sposób pracy marketerów, zespołów SEO, researcherów i programistów. Coraz częściej to nie jeden model rozwiązuje całe zadanie, lecz zestaw narzędzi dobieranych pod konkretny etap pracy.

Jak działają modele generatywne i gdzie ChatGPT ustępuje konkurencji?

Większość opisywanych tutaj narzędzi opiera się na dużych modelach językowych (LLM). To sieci neuronowe typu transformer, trenowane na bilionach tokenów tekstu. Po podaniu promptu model przewiduje kolejne tokeny, dlatego potrafi pisać teksty, pisać kod, tłumaczyć, podsumowywać dokumenty albo prowadzić rozmowę.

Różnice zaczynają się w szczegółach technicznych. Parametry, które wpływają na użyteczność to:

- maksymalne okno kontekstu, czyli liczba tokenów, którą model może przyjąć w jednym zadaniu,

- sposób pozyskiwania aktualnych danych, czyli to, czy narzędzie pracujące na modelu potrafi wykonywać zapytania do internetu i korzystać z bieżących informacji,

- multimodalność, czyli praca nie tylko na tekście, ale też na obrazie, dźwięku czy wideo,

- możliwość używania narzędzi zewnętrznych (wyszukiwarki, interpreter kodu, kalkulator, wirtualny komputer),

- sposób wdrożenia, na przykład API w chmurze kontra otwarty model instalowany na własnej infrastrukturze.

ChatGPT wciąż oferuje bardzo mocny model tekstowy, ale ma wyraźne ograniczenia. Standardowe wersje działają na danych zamkniętych do konkretnej daty, dlatego bez mechanizmów wyszukiwania nie korzystają z najnowszych informacji. Okno kontekstu w typowych planach jest mniejsze niż w modelach Claude czy Llama 3.1. ChatGPT jest też modelem zamkniętym, więc jego wewnętrzne parametry nie są publicznie dostępne, co uniemożliwia pełne wdrożenie na własnym serwerze albo dostosowanie modelu poprzez dalsze trenowanie.

Google Gemini – AI oparte o ekosystem Google i bieżące dane

Gemini to multimodalna rodzina modeli Google DeepMind obsługująca tekst, obraz, audio, wideo i kod. Najnowsza generacja, Gemini 3, osiąga ponad 50% lepsze wyniki w testach złożonych zadań w porównaniu z Gemini 2.5 Pro, co Google prezentuje jako największy skok jakości w historii tej linii modeli. Tak duży wzrost pokazuje, że model przeszedł ewolucję w zakresie rozumowania, analizy danych i zadań wieloetapowych.

Ekosystem Gemini obejmuje również specjalizowane moduły:

- Flash Image do generowania obrazów,

- obsługę audio (transkrypcja i generowanie mowy),

- tryb Gemini Agent, który wykonuje wieloetapowe zadania takie jak porządkowanie skrzynki mailowej czy automatyzacja procesów w Workspace.

Najważniejszym elementem Gemini jest natywna praca w środowisku Google. Model działa bezpośrednio w wyszukiwarce (w formie odpowiedzi AI), Gmailu, Dokumentach Google i Arkuszach, więc użytkownik pracuje na aktualnych danych z ekosystemu Google oraz własnych plikach zapisanych w Workspace. Gemini wyróżnia więc połączenie bardzo dużego kontekstu, multimodalności, zintegrowanego środowiska pracy i aktualnych danych z wyszukiwarki.

Kolejnym elementem, który wzmacnia zastosowania biznesowe, jest pełna dostępność Gemini 3 w API dla deweloperów przez Google AI Studio, Vertex AI oraz CLI. Dzięki temu model można włączyć w procesy B2B, automatyzacje, systemy obsługi klienta, aplikacje firmowe i wewnętrzne pipeline’y. To cecha, która w praktyce otwiera drogę do wdrażania Gemini jako komponentu infrastruktury, a nie jedynie chatbota.

Gemini 3 łączy też elementy wcześniejszych generacji (multimodalność, duży kontekst, szybkie modele Flash i obsługę narzędzi) tworząc linię modelową, którą Google określa jako pełnoprawną alternatywę dla GPT i Claude.

Microsoft Copilot – generowanie treści z oparciem o Bing i narzędzia Microsoft

Microsoft Copilot działa jako zestaw asystentów AI dostępnych w ekosystemie Microsoft: w Wordzie, Excelu, PowerPoincie, Outlooku, Teams i systemie Windows, a także w GitHub Copilot, co odróżnia go od pojedynczych modeli takich jak ChatGPT. Integracja z Microsoft Graph umożliwia pracę na danych firmowych – korespondencji, dokumentach, arkuszach i kalendarzach – dzięki czemu Copilot generuje treści i analizy na podstawie realnego kontekstu organizacji, a nie jedynie dane treningowe.

GitHub Copilot korzysta z GPT-4-turbo i obsługuje kontekst 64 000 tokenów, a jednocześnie działa bezpośrednio w IDE, mając dostęp do bieżących plików projektu. W praktyce umożliwia to podpowiedzi w czasie pisania, analizę błędów, diagnostykę i generowanie kodu opartego na całym repozytorium, czego ChatGPT nie posiada bez ręcznego wprowadzenia kodu do czatu. Copilot ma również dwa tryby pracy, szybki tryb generowania oraz rozszerzony tryb analizy („Think Deeper”), który przygotowuje dłuższe i bardziej uzasadnione rozwiązania.

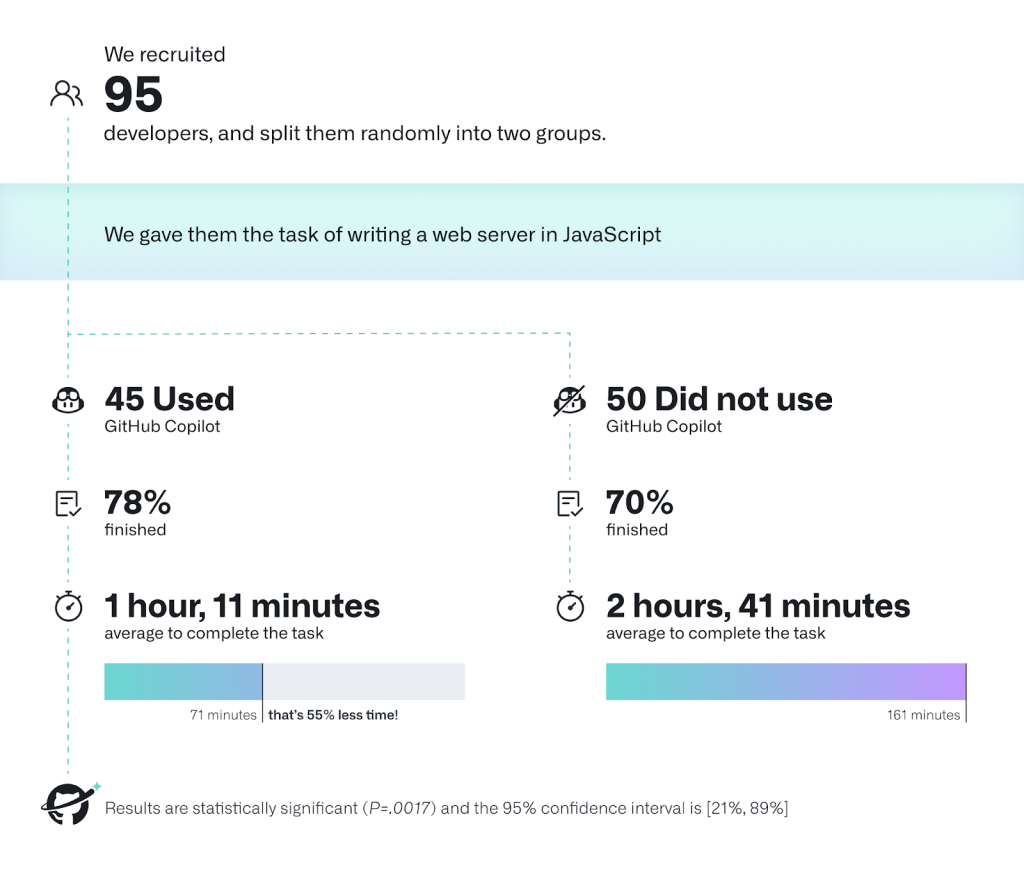

W środowisku firmowym Copilot zapewnia przewidywalną integrację z narzędziami Microsoft 365, umożliwiając tworzenie dokumentów, podsumowań, prezentacji lub maili na podstawie danych z Graph. Badania GitHub wskazują, że wykorzystanie Copilota przyspiesza wykonywanie powtarzalnych zadań programistycznych nawet o 55 procent. Nie jest natomiast dostępny jako otwarte API, działa on w ramach ekosystemu Microsoft, co czyni go narzędziem zaprojektowanym przede wszystkim do pracy korporacyjnej, a nie jako niezależna platforma deweloperska.

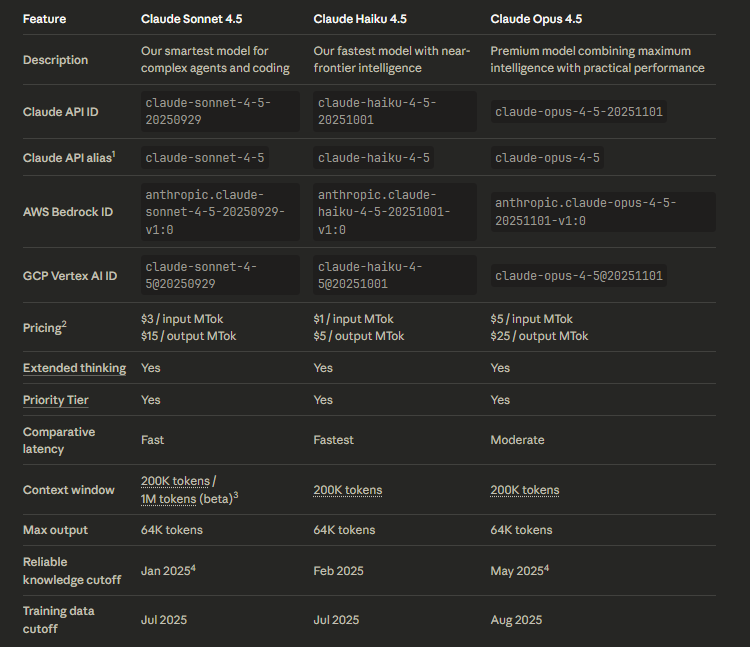

Claude (Anthropic) – model o największym kontekście i najstabilniejszej jakości

Claude to model rozwijany przez Anthropic, zaprojektowany pod kątem stabilności i precyzyjnego rozumowania. Jego najbardziej charakterystyczną cechą jest bardzo duże okno kontekstu – w wersjach Claude 3 dostępne jest 200 000 tokenów, a w konfiguracjach eksperymentalnych nawet 1 milion tokenów. Tak duża pojemność pozwala analizować obszerne dokumenty, wielostronicowe raporty czy duże fragmenty repozytoriów kodu w jednym zadaniu.

Anthropic stosuje podejście Constitutional AI, które ogranicza halucynacje i wymusza bardziej uzasadnione odpowiedzi. Model dobrze utrzymuje spójność wypowiedzi na dłuższej przestrzeni i potrafi pracować w stylu użytkownika, dlatego sprawdza się w zadaniach redakcyjnych, analizach merytorycznych oraz w pracy z długą treścią.

Claude oferuje także tryby pracy, które wpływają na sposób generowania odpowiedzi, szybsze odpowiedzi w zadaniach prostych oraz dokładniejsze, krokowe rozumowanie przy zapytaniach bardziej złożonych. Podobne mechanizmy występują również w innych modelach, takich jak Gemini czy GPT, jednak w przypadku Claude tryby te działają w połączeniu z dużym kontekstem, co zwiększa ich użyteczność w pracy na dużych zbiorach danych. Model radzi sobie również dobrze w zadaniach programistycznych. Anthropic rozwija dedykowany moduł Claude Code, a duży kontekst pozwala mu analizować wiele plików jednocześnie oraz proponować poprawki w oparciu o całość repozytorium, a nie tylko pojedynczy fragment kodu.

Perplexity AI – najlepsze narzędzie do researchu

Perplexity AI działa jak wyszukiwarka oparta na modelu językowym. Każde zapytanie uruchamia pobieranie danych w czasie rzeczywistym, a generowane odpowiedzi zawierają pełną listę źródeł. Model nie pracuje wyłącznie na danych treningowych, lecz na bieżąco analizuje dostępne informacje, co znacząco odróżnia go od ChatGPT, Claude czy Gemini działających w trybach bez wyszukiwania. W praktyce Perplexity jest dziś najsilniejszym narzędziem do researchu, bo jako jedyne łączy model językowy z natywnym wyszukiwaniem i pełnym zestawem źródeł.

Perplexity obsługuje tryb Search Focus, który pozwala zawężać wyniki do danych z internetu, publikacji naukowych, zadań matematycznych lub wsparcia pisania. W zadaniach analitycznych pomaga to eliminować nieistotne źródła i skupić się na typie treści, który jest ważny dla danego projektu. W trybie Copilot narzędzie przeprowadza wieloetapowy research: analizuje SERP, filtruje linki, sprawdza wiarygodność materiałów i sugeruje kierunki pogłębiania tematu.

W pracy codziennej pomocne są Spaces, które umożliwiają tworzenie kolekcji zapytań i materiałów. To praktyczna funkcja przy budowie baz wiedzy, analizach tematycznych i projektach SEO prowadzonych w zespołach. Perplexity nie zastępuje kreatywnych modeli generatywnych, lecz uzupełnia je w krytycznym obszarze pracy z informacją: szybkim researchu, weryfikacji danych i analizie wyników wyszukiwarki. Nie sprawdza się natomiast jako narzędzie do pisania dłuższych tekstów.

Llama 3 / 3.1 – otwarty model dla firm i developerów

Llama 3 / 3.1 to otwarte modele od Meta, zaprojektowane z myślą o firmach i zespołach technicznych, które potrzebują pełnej kontroli nad danymi i sposobem wdrożenia. Modele można uruchamiać lokalnie, w środowiskach chmurowych lub w ramach własnych aplikacji, co odróżnia je od rozwiązań zamkniętych, takich jak ChatGPT czy Gemini. Llama 3.1 występuje w wariantach 8 miliardów, 70 miliardów oraz 405 miliardów parametrów. Największy model osiąga wyniki na benchmarku MMLU na poziomie 87,3 procent, co plasuje go w okolicach GPT 4 Turbo i Claude 3 Opus.

Otwarta architektura umożliwia fine-tuning, dostosowanie modelu do języka branżowego oraz integrację z istniejącymi systemami firmy. Dzięki temu Llama sprawdza się tam, gdzie liczy się prywatność, skalowalność i możliwość utrzymania modelu we własnym środowisku. Modele te radzą sobie dobrze w zadaniach klasyfikacji, analizy treści, tworzenia szkiców tekstów czy pracy na dużych zbiorach dokumentów. Llama jest więc modelem elastycznym, skierowanym nie do użytkownika końcowego, lecz do firm i developerów, którzy chcą tworzyć własne rozwiązania AI z pełną kontrolą nad danymi.

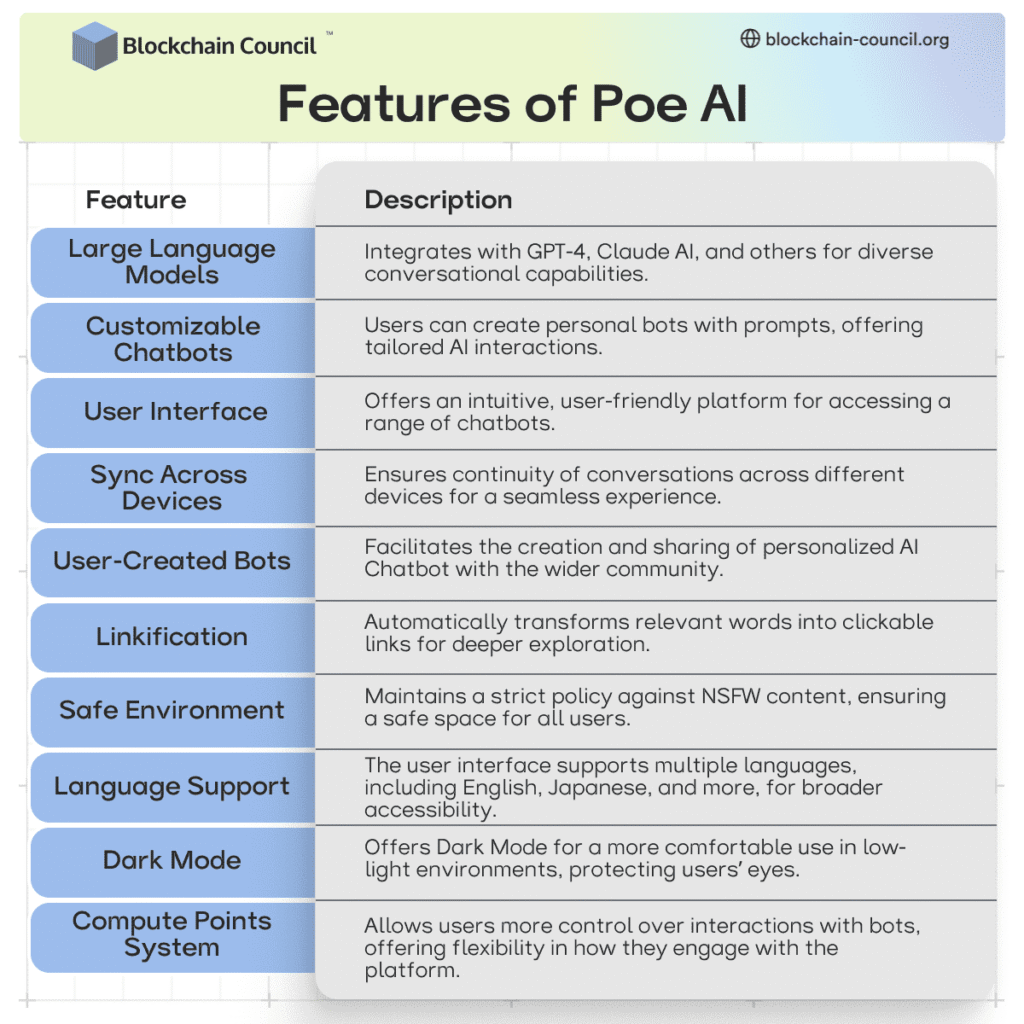

Poe AI – platforma agregująca różne modele

Poe AI to platforma, która w jednym miejscu udostępnia wiele zaawansowanych modeli. Wśród nich znajdują się GPT 5.1, Claude Sonnet 4.5, Gemini 3 Pro, DeepSeek R1, Veo 3.1 oraz tysiące botów tworzonych przez społeczność. Poe działa jako warstwa dostępu do różnych systemów. Użytkownik nie musi przełączać aplikacji ani zakładać nowych kont, aby testować zachowanie kilku modeli jednocześnie. Dzięki temu platforma sprawdza się przy porównywaniu odpowiedzi, szybkim prototypowaniu zapytań i pracy nad treściami wymagającymi różnych stylów generacji.

Platforma pozwala tworzyć własne boty oparte na promptach, regułach i wybranych modelach, co ułatwia automatyzację powtarzalnych zadań oraz budowę prostych agentów. Udostępnione API umożliwia integrację Poe z innymi narzędziami wykorzystywanymi w firmie. W efekcie Poe pełni funkcję elastycznego narzędzia do testowania i researchu, a nie zastępstwa dla samodzielnych platform takich jak ChatGPT czy Gemini. Jej główną zaletą jest możliwość szybkiego wyboru modelu, który najlepiej pasuje do konkretnego zadania.

Copy.ai i Jasper jako narzędzia automatyzujące produkcję treści marketingowych

Copy.ai i Jasper to narzędzia tworzone z myślą o zespołach marketingowych, które potrzebują powtarzalnych formatów treści i uporządkowanych procesów pracy. Obie platformy działają na modelach generatywnych, lecz ich przewaga nie wynika z jakości samego silnika, tylko z gotowych workflow, zestawów promptów i modułów automatyzujących tworzenie treści. Narzędzia te pozwalają szybko przygotować opisy produktów, posty do social media, treści mailingowe, krótkie komunikaty reklamowe i szkice artykułów.

Copy.ai oferuje rozbudowany system automatyzacji, w którym można budować sekwencje działań oparte na promptach i danych wejściowych. Sprawdza się to w kampaniach e-commerce, social media oraz w pracy na dużej liczbie powtarzalnych komunikatów. Jasper rozwija szablony treści oraz funkcje związane z brand voice, które pomagają zachować spójność stylistyczną materiałów tworzonych na potrzeby firmy.

Narzędzia te ułatwiają pracę marketerom, lecz nie zastąpią modeli ogólnego zastosowania w zadaniach wymagających analizy, researchu lub tworzenia dłuższych treści eksperckich. Ich rolą jest usprawnienie procesów i przyspieszenie produkcji treści operacyjnych

Porównanie alternatyw ChatGPT według zastosowań

| Narzędzie / Model | Najważniejsze cechy techniczne | Różnica względem ChatGPT | Ograniczenia |

| Google Gemini 3 | Bardzo duży kontekst (do 1M tokenów), pełna multimodalność, moduły Agent i Computer Use, natywna integracja z Google Workspace, bieżące dane z wyszukiwarki. | Dostęp do danych z Gmaila, Docs i Drive jest natywny, bez konfiguracji. Lepsza multimodalność i integracja z ekosystemem Google. Mocniejszy w zadaniach operacyjnych opartych na realnych danych. | Model zamknięty. Brak możliwości hostingu lokalnego. Najlepiej działa w ekosystemie Google. |

| Microsoft Copilot | Integracja z Microsoft Graph, praca na dokumentach firmowych, mailach i spotkaniach, automatyzacje w Word, Excel, Outlook i Teams. GitHub Copilot do kodu. | W pracy biurowej mocniejszy niż ChatGPT dzięki natywnej integracji z plikami firmowymi. ChatGPT wymaga ręcznego udostępniania danych. | Ograniczony do środowiska Microsoft 365. Mniej elastyczny poza ekosystemem MS. |

| Claude (Anthropic) | Kontekst 200k–1M tokenów, bardzo niska halucynacyjność (Constitutional AI), stabilność w analizie dokumentów i kodu. | Lepszy w długich dokumentach i analizie złożonych repozytoriów. Bardziej przewidywalny i mniej podatny na halucynacje. | Model zamknięty. Brak hostingu własnego. Mniej kreatywny niż GPT w niektórych zadaniach. |

| Perplexity AI | Wyszukiwanie w czasie rzeczywistym, Search Focus, Copilot do researchu etapowego, filtrowanie spamu, źródła pod odpowiedziami. | ChatGPT przetwarza głównie dane treningowe, Perplexity pobiera informacje na żywo. Odpowiedzi są bardziej aktualne i transparentne. | Nie generuje długiej treści. Nie zastąpi modeli ogólnych. Służy głównie do researchu. |

| Llama 3 / 3.1 | Modele open weight, możliwość hostingu lokalnego, fine-tuning, kontrola nad danymi, długi kontekst 128k. | Pełna kontrola nad modelem oraz prywatność wdrożenia, czego ChatGPT nie oferuje. Idealne dla firm budujących własne systemy AI. | Wymaga infrastruktury i kompetencji technicznych. Jakość zależy od wdrożenia. |

| Poe AI | Agregator modeli. Dostęp do wielu LLM w jednym miejscu. Tworzenie własnych botów. API do integracji. | Poe nie konkuruje bezpośrednio z ChatGPT jako model. Jego przewaga to możliwość porównania ChatGPT z innymi modelami w jednym środowisku. | Brak kontroli nad modelami. Ograniczenia wynikają z wybranego LLM. |

| Copy.ai | Automatyzacje marketingowe i sprzedażowe, workflow GTM, szybka generacja krótkich treści, Infobase. | Nie konkuruje z ChatGPT jako model. Wyróżnia się gotowymi procesami, których ChatGPT nie posiada. | Ograniczone do marketingu i krótkich formatów. Brak zaawansowanego reasoning. |

| Jasper | Brand voice, style guides, Jasper Canvas, workflow marketingowe, baza wiedzy. | Lepszy w utrzymaniu spójnego stylu marki i organizacji kampanii. ChatGPT wymaga ręcznego budowania stylów. | Ograniczone do marketingu. Nie analizuje danych, nie robi researchu, nie obsługuje dużych dokumentów. |

Różnice w funkcjonalności są wyraźne, dlatego nie ma jednego narzędzia odpowiedniego do wszystkich zastosowań. Przegląd alternatyw pokazuje, jak szeroki i zróżnicowany stał się ekosystem modeli, które mogą uzupełniać lub zastępować ChatGPT w wybranych obszarach. Takie spojrzenie ułatwia ocenę, które rozwiązania warto brać pod uwagę przy pracy nad konkretnymi procesami lub zadaniami.

- Jak działają modele generatywne i gdzie ChatGPT ustępuje konkurencji?

- Google Gemini – AI oparte o ekosystem Google i bieżące dane

- Microsoft Copilot – generowanie treści z oparciem o Bing i narzędzia Microsoft

- Claude (Anthropic) – model o największym kontekście i najstabilniejszej jakości

- Perplexity AI – najlepsze narzędzie do researchu

- Llama 3 / 3.1 – otwarty model dla firm i developerów

- Poe AI – platforma agregująca różne modele

- Copy.ai i Jasper jako narzędzia automatyzujące produkcję treści marketingowych

- Porównanie alternatyw ChatGPT według zastosowań