Dlaczego Twoja strona nie wyświetla się w Google i jak to naprawić?

Czasem zdarza się, że nowa strona internetowa nie pojawia się w wynikach wyszukiwania Google, mimo że wydaje się działać poprawnie. Przyczyny mogą być różne – od problemów technicznych, przez brak odpowiednich treści, po specyfikę technologii użytej do jej stworzenia. Przyjrzymy się najczęstszym problemom związanym z indeksowaniem i podpowiemy, co zrobić, by poprawić widoczność witryny.

Na czym polega indeksacja?

Indeksacja to proces, w którym wyszukiwarka analizuje zawartość strony i zapisuje ją w swoim indeksie, umożliwiając wyświetlenie jej w wynikach wyszukiwania. Aby strona mogła zostać zaindeksowana, musi być dostępna dla Googlebota, który pobiera jej zawartość, a następnie analizuje treści, strukturę i elementy techniczne. Jeśli strona nie spełnia wymagań wyszukiwarki – na przykład zawiera błędy techniczne, zduplikowane treści lub jest zablokowana – może nie zostać zaindeksowana, co uniemożliwia jej widoczność w Google. Każda witryna ma ograniczony „budżet indeksowania” (crawl budget), czyli liczbę podstron, które Googlebot odwiedzi i przetworzy w danym okresie. Stopień indeksacji ma znaczący wpływ na pozycjonowanie strony i osiągane przez nią wyniki.

Blokowanie dostępów dla robotów indeksujących

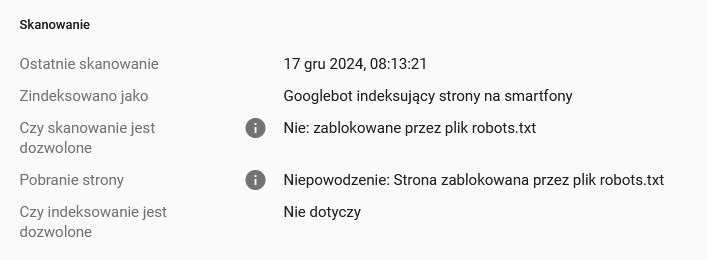

Jednym z najczęstszych powodów, dla których strona nie pojawia się w wynikach wyszukiwania Google, jest celowe lub przypadkowe zablokowanie jej indeksowania. Istnieje kilka metod, za pomocą których można uniemożliwić robotom wyszukiwarki dostęp do treści strony. Te rozwiązania są często stosowane w trakcie budowy strony, gdy właściciele chcą, aby witryna była niewidoczna do momentu jej ukończenia, jednak ich nieodpowiednie usunięcie po publikacji może prowadzić do poważnych problemów z widocznością. Oto najpopularniejsze sposoby blokowania indeksacji:

- Plik robots.txt: Służy do kierowania robotów wyszukiwarek. Przykładowy zapis:

User-agent: *

Disallow: /

- Meta tag noindex: Umieszczony w sekcji <head> strony. Przykład:

<meta name=”robots” content=”noindex”>

- Nagłówki HTTP: Instrukcja X-Robots-Tag: noindex ustawiona na poziomie serwera blokuje indeksowanie.

Sprawdzenie i usunięcie tych blokad czy meta tagów to pierwszy krok do poprawy widoczności strony w wyszukiwarce. Oprócz ręcznego sprawdzenia kodu źródłowego można to zrobić także z pomocą wtyczek takich jak nap. Nofollow czy Link Redirect Trace.

informacja z Google Search Console o zablokowaniu przed indeksacją

Najczęstsze problemy technologiczne wpływające na indeksację

Technologia wykorzystana do budowy strony internetowej ma istotny wpływ na to, jak Google indeksuje jej zawartość. Strony statyczne, oparte na HTML i CSS, są łatwiejsze do zrozumienia dla robotów wyszukiwarki, ponieważ cała ich treść jest dostępna już w momencie ładowania strony. Inaczej jest w przypadku stron dynamicznych, które generują treści w przeglądarce użytkownika za pomocą JavaScriptu. W takich przypadkach Googlebot musi wykonać dodatkowy krok – renderowanie strony, co czasami prowadzi do problemów z indeksacją. Frameworki takie jak React czy Angular oferują ogromne możliwości w zakresie budowy dynamicznych stron, ale wymagają odpowiedniego dostosowania, aby były przyjazne wyszukiwarkom. Brak pełnej treści w kodzie HTML lub zablokowane zasoby JavaScript mogą sprawić, że Google nie będzie w stanie poprawnie odczytać zawartości strony. Dlatego popularnym rozwiązaniem jest renderowanie po stronie serwera (Server-Side Rendering), które generuje gotowy kod HTML widoczny dla robotów już w momencie ich wejścia na stronę.

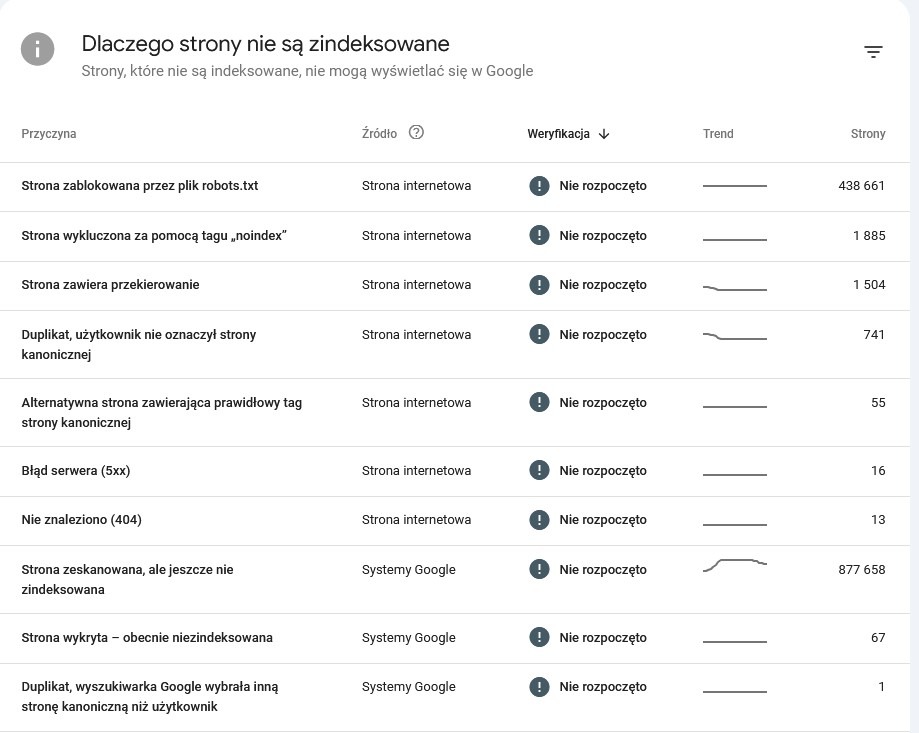

Problemy techniczne i ich wpływ na widoczność

Problemy techniczne mogą znacząco wpłynąć na widoczność strony w Google, ponieważ uniemożliwiają robotom wyszukiwarki prawidłowe odczytanie i zindeksowanie jej zawartości. Nawet dobrze zoptymalizowana pod kątem treści strona nie pojawi się w wynikach wyszukiwania, jeśli boryka się z błędami technicznymi.

Jednym z najczęstszych problemów są błędy w pliku robots.txt, który może blokować dostęp robotów do kluczowych części witryny, takich jak podstrony lub zasoby JavaScript i CSS. Taki błąd sprawia, że strona nie jest prawidłowo renderowana, a jej treść może pozostać niewidoczna dla Google.

Częste problemy techniczne obejmują:

- Błędy 404 – Brakujące strony, które powodują, że użytkownik lub robot wyszukiwarki trafia na nieistniejącą treść.

- Brak przekierowań – Po zmianie struktury URL brak przekierowań 301 prowadzi do utraty wartości linków (link juice).

- Zbyt wolne ładowanie strony – Może wynikać z nieoptymalnych obrazów, ciężkich plików JavaScript lub słabego hostingu.

- Niedostosowanie do urządzeń mobilnych – W kontekście Mobile-First Indexing brak responsywności strony obniża jej ocenę w Google.

- Nieprawidłowe tagi kanoniczne – Brak lub złe ustawienie znacznika rel=”canonical” może prowadzić do problemów z duplikacją treści i rozproszenia wartości linków między podobnymi adresami URL.

- Błędy w konfiguracji serwera – Problemy z ustawieniami serwera, takie jak niewłaściwe nagłówki HTTP (np. 500 Internal Server Error), mogą blokować dostęp do strony.

- Problemy z dostępnością treści – Treści ukryte za interakcjami, takimi jak rozwijane sekcje lub dynamicznie ładowane elementy, mogą być trudne do odczytania przez roboty wyszukiwarek.

Czas ładowania witryny jest szczególnie ważny, ponieważ strony, które ładują się zbyt wolno, nie tylko zniechęcają użytkowników, ale również obniżają ranking w wyszukiwarce. Google kładzie duży nacisk na wydajność, więc warto regularnie sprawdzać szybkość ładowania za pomocą narzędzi takich jak PageSpeed Insights.

W raporcie GSC poświęconym indeksacji stron możemy zobaczyć listę problemów. Trzeba jednak pamiętać, że niektóre blokady indeksacji są celowe i pewne komunikaty zawsze się będą tutaj pojawiać.

Bezpieczeństwo i aktualizacje

Problemy z bezpieczeństwem, takie jak ataki hakerskie czy zainfekowanie strony złośliwym oprogramowaniem, mogą znacząco wpłynąć na jej widoczność w Google. Strony przejęte przez hakerów lub zawierające malware są oznaczane jako niebezpieczne, co skutkuje ostrzeżeniami w wynikach wyszukiwania, a w skrajnych przypadkach ich całkowitym usunięciem z indeksu. Dodatkowo brak certyfikatu SSL (HTTPS) powoduje, że witryna jest oznaczana jako „niezabezpieczona”, co obniża jej ranking i zniechęca użytkowników. Aby uniknąć takich problemów, warto zadbać o kilka kluczowych aspektów bezpieczeństwa:

- regularne aktualizacje systemu CMS i wtyczek,

- wdrożenie certyfikatu SSL,

- monitorowanie strony pod kątem złośliwego oprogramowania,

- zabezpieczenie formularzy i komentarzy przed spamem.

Dzięki tym działaniom strona nie tylko zyska ochronę przed zagrożeniami, ale także utrzyma zaufanie użytkowników i wyszukiwarek.

Filtry i kary od Google

Filtry i kary Google to mechanizmy stosowane przez wyszukiwarkę w celu ochrony jakości wyników wyszukiwania i eliminowania stron naruszających wytyczne dotyczące jakości. Kary mogą być nałożone ręcznie przez pracowników Google lub automatycznie przez algorytmy, takie jak Panda, który penalizuje niskiej jakości treści, czy Penguin, który zwalcza nienaturalne praktyki linkowania.

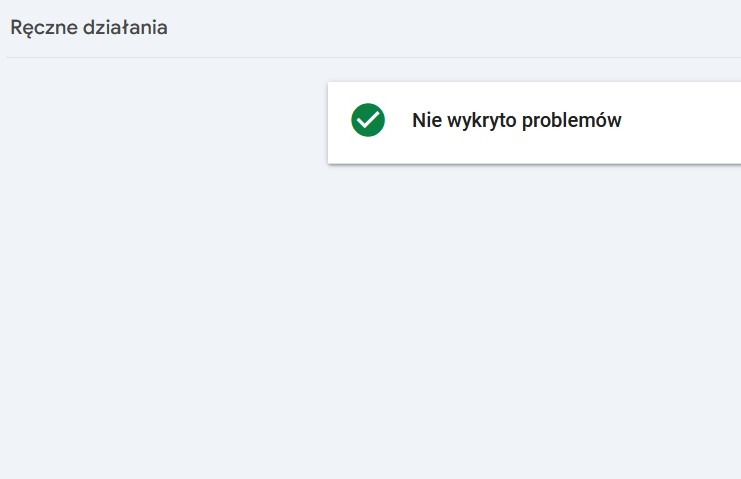

Kary ręczne są wyraźnie sygnalizowane w Google Search Console w sekcji „Ręczne działania”. W takich przypadkach właściciel witryny otrzymuje informację o naruszeniu i instrukcje, jak je naprawić. Filtry nakładane automatycznie przez algorytmy są mniej oczywiste – Google nie informuje o nich bezpośrednio, a ich działanie można zauważyć w postaci nagłego spadku ruchu organicznego lub pozycji w wynikach wyszukiwania. Aby zidentyfikować filtr, konieczne jest przeanalizowanie danych w narzędziach takich jak Google Analytics i Search Console oraz porównanie spadków ruchu z datami aktualizacji algorytmów. Aby uniknąć takich sytuacji, należy przestrzegać wytycznych Google, tworzyć wartościowe treści, budować naturalne linki zwrotne i regularnie analizować stronę pod kątem potencjalnych naruszeń. W przypadku kary ręcznej konieczne jest naprawienie błędów i złożenie wniosku o ponowne rozpatrzenie, podczas gdy skutki filtrów można złagodzić poprzez poprawę jakości treści i strategii SEO.

Informacja na temat braku działań ręcznych w Google Search Console

Intencja użytkownika i wartość strony docelowej

Widoczność strony na konkretne frazy kluczowe w dużej mierze zależy od dopasowania treści do intencji wyszukiwania użytkownika oraz od poziomu konkurencji. Google analizuje, czy strona odpowiada na pytanie lub potrzebę stojącą za danym zapytaniem – na przykład, czy jest to intencja informacyjna, transakcyjna czy nawigacyjna. Jeśli treść strony nie spełnia tej intencji, może zostać pominięta lub wyświetlona na dalszych pozycjach, nawet jeśli jest technicznie poprawna i dobrze zoptymalizowana. Jednocześnie frazy o wysokim poziomie konkurencji mogą wymagać znacznych inwestycji w jakość treści i linkowanie, aby strona była zauważalna. Dlatego dla nowych stron lub witryn bez silnego autorytetu lepszym rozwiązaniem jest skupienie się na mniej konkurencyjnych frazach długiego ogona, które łatwiej zaindeksować i wypozycjonować.

Wolna indeksacja nowych serwisów – w czym problem?

Nowe strony internetowe często mają trudności z pojawieniem się w wynikach wyszukiwania Google. Wynika to z kilku czynników, które wpływają na szybkość i efektywność indeksacji. Proces ten może trwać od kilku dni do nawet kilku miesięcy, szczególnie jeśli nie podjęto odpowiednich działań wspierających widoczność witryny. Oto najważniejsze kwestie, które negatywnie wpływają na indeksację nowych stron:

- Brak autorytetu domeny – Nowe domeny są traktowane z ograniczonym zaufaniem przez Google. Brak historii, linków zwrotnych i sygnałów jakości sprawia, że algorytmy wyszukiwarki mogą potrzebować więcej czasu, aby zaindeksować stronę.

- Brak linków przychodzących – Linki z innych zaindeksowanych witryn są jednym z głównych sposobów, w jaki Googlebot odkrywa nowe strony. Bez takich linków roboty mogą mieć trudności z dotarciem do witryny.

- Brak zgłoszenia strony w Google Search Console – Jeśli nowa strona nie zostanie zgłoszona za pomocą narzędzia Google Search Console i nie posiada mapy witryny XML, wyszukiwarka może wolniej zidentyfikować wszystkie podstrony.

- Problemy z treścią – Strony zawierające powielone treści, niską wartość merytoryczną lub treści generowane automatycznie mogą zostać uznane za mniej wartościowe, co opóźnia ich indeksację lub obniża widoczność.

Czy Sandbox istnieje?

W maju 2024 roku wyciekła dokumentacja Google, która ujawniła istnienie parametru „hostAge”. Jest to jeden z czynników, według których algorytmy wyszukiwarki oceniają nowe strony internetowe, uwzględniając czas istnienia domeny lub hostingu. Parametr ten pozwala Google lepiej weryfikować jakość i wiarygodność nowo powstałych witryn. Nowe strony, pozbawione historii, linków zwrotnych i ugruntowanej pozycji, mogą być uznane za mniej wiarygodne w pierwszych tygodniach czy miesiącach od ich publikacji. Chociaż Google oficjalnie zaprzecza istnieniu tzw. „sandboxu”, wyciek ten potwierdził, że nowe witryny mogą być poddawane bardziej rygorystycznej ocenie przed osiągnięciem pełnej widoczności w wynikach wyszukiwania. „HostAge” wskazuje, że algorytmy wyszukiwarki ostrożnie podchodzą do stron bez historii, co czasami przypomina okres „karencji”. Aby złagodzić wpływ tego czynnika, warto skoncentrować się na budowaniu wartościowych treści, zdobywaniu jakościowych linków zwrotnych i przestrzeganiu zasad optymalizacji SEO.

Widoczność w Google – wpływ wielu czynników

Widoczność w wynikach wyszukiwania Google to efekt współdziałania różnych czynników. Strona musi być technicznie poprawna – bez błędów, blokad indeksowania i problemów z szybkością ładowania. Jednocześnie istotna jest jakość treści: unikalne, wartościowe materiały odpowiadające na intencje użytkowników są podstawą sukcesu. Nie można też zapominać o znaczeniu autorytetu domeny – bez linków zwrotnych z wiarygodnych źródeł algorytmy wyszukiwarki traktują witrynę z mniejszym zaufaniem. Najważniejszy wniosek: widoczność to nie kwestia jednorazowej optymalizacji, ale ciągłego procesu. Współdziałanie technologii, treści i strategii linkowania wymaga regularnej analizy i dostosowywania działań, by skutecznie konkurować w środowisku wyszukiwarek.

- Na czym polega indeksacja?

- Blokowanie dostępów dla robotów indeksujących

- Najczęstsze problemy technologiczne wpływające na indeksację

- Problemy techniczne i ich wpływ na widoczność

- Bezpieczeństwo i aktualizacje

- Filtry i kary od Google

- Intencja użytkownika i wartość strony docelowej

- Wolna indeksacja nowych serwisów – w czym problem?

- Czy Sandbox istnieje?

- Widoczność w Google – wpływ wielu czynników

![Algorytmy Google – rodzaje i działanie [2026]](https://webmetric.com/wp-content/uploads/2025/11/algorytmy-google.jpg)