Co to jest wyszukiwarka internetowa i jak działa?

Znajdź w Google. Wygugluj sobie. Wielokrotnie słyszeliśmy takie zdanie, po czym otwieraliśmy dowolną przeglądarkę na aktualnie używanym urządzeniu, wpisywaliśmy zagadnienie, do którego odpowiedzi szukaliśmy i czekaliśmy, co nam Google pokaże.

Z czego tak naprawdę korzystaliśmy? Jaki wpływ mają wyszukiwarki na to, co przeglądamy w Internecie? Na te i kilka innych pytań postaram się odpowiedzieć w poniższym artykule.

Co to jest wyszukiwarka internetowa?

Wyszukiwarka internetowa to narzędzie online, które umożliwia użytkownikom szybkie znajdowanie informacji w internecie na podstawie wprowadzonych słów kluczowych. Działa poprzez indeksowanie treści dostępnych na stronach internetowych i udostępnianie ich w formie uporządkowanych wyników wyszukiwania w odpowiedzi na zapytania użytkowników. To dzięki wyszukiwarkom możemy obecnie łatwo i szybko znaleźć teksty, obrazy, filmy, produkty, mapy, czy inne materiały dostępne w Internecie.

Historia wyszukiwarek internetowych

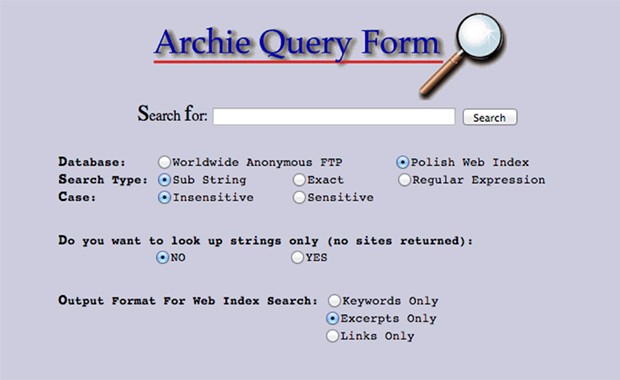

W latach 90. XX wieku Internet niczym nie przypominał obecnego medium, w którym za pomocą kilku kliknięć możemy znaleźć wszystkie pożądane przez nas informacje. Tak samo pierwsze wyszukiwarki internetowe różniły się od obecnych, zarówno wyglądem jak i sposobem działania. W związku z rozwojem infrastruktury internetowej w 1990 roku, dzięki Alanowi Emtage’owi powstała pierwsza wyszukiwarka internetowa Archie.

W 2023 roku, Archie nadal było działającym narzędziem m.in. na serwerze Uniwersytetu Warszawskiego

Zadaniem tej wyszukiwarki było ułatwienie dostępu do plików znajdujących się na serwerach FTP (w latach 90 był to popularny sposób na udostępnianie danych w Internecie). Samo działanie tej wyszukiwarki było proste: program regularnie przeszukiwał publiczne serwery FTP oraz katalogował zawarte na nich pliki na podstawie nazwy oraz ich lokalizacji. Użytkownik, chcąc coś wyszukać, po dodaniu zapytania tekstowego otrzymywał listę plików z informacjami o serwerach, na których się znajdowały. Co ważne – Archie tworzył katalogi na podstawie metadanych plików – nie przeglądał ich zawartości.

Kolejnymi narzędziami o podobnym działaniu były Veronica czy Jughead jednakże przełomem okazało się stworzenie World Wide Web przez Tima Bernersa-Lee co przyczyniło się do rozwoju systemów indeksujących treści.

W 1993 roku powstała pierwsza wyszukiwarka WWW o nazwie World Wide Web Wanderer, której zadaniem było indeksowanie nowych stron internetowych. W niedalekiej przyszłości pojawiły się bardziej zaawansowane projekty, które trafiły (lub były bardzo blisko trafienia) również na polskie podwórko, takie jak Lycos, AltaVista, czy Yahoo!.

Do 2010 roku można uznać, że utworzyło się najwięcej narzędzi do przeglądania stron internetowych, które w jakiś sposób mogły ukształtować obecny wygląd Internetu.

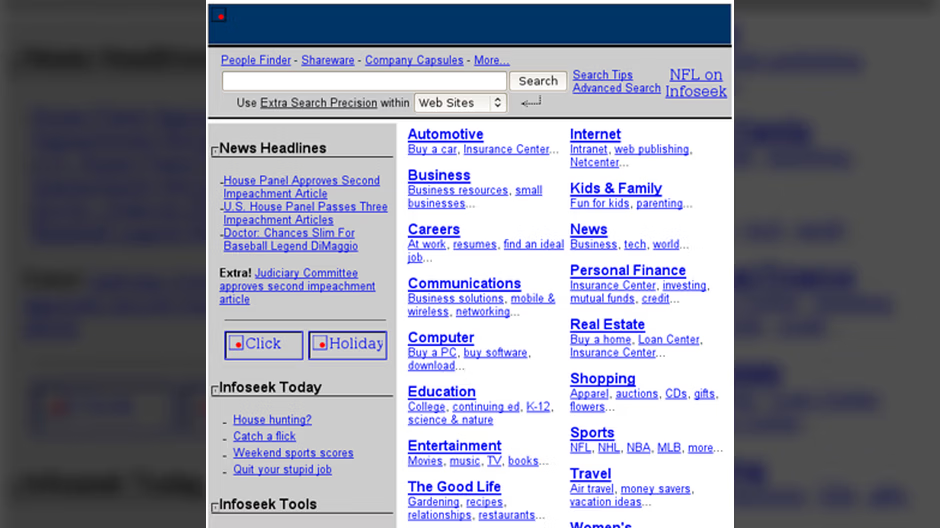

Po AltaViście w 1995 roku powstało Yahoo!, które początkowo pełniło rolę jedynie katalogu internetowego, który z czasem zintegrował wyszukiwarkę internetową. Rok później powstało Inktomi, które przyczyniło się wsparcia przetwarzania dużych zbiorów danych, a w 1998 powstało Google, początkowo jako wyszukiwarka w sieci uczelnianej, z czasem stając się liderem na międzynarodowym rynku.

Infoseek był wyszukiwarką obsługującą polskie znaki, a na jej silniku “UltraSeek Server” do 2000 roku oparta była wyszukiwarka między innymi serwisu Onet.pl

2000 rok zapisał się w historii wyszukiwarek dzięki uruchomieniu chińskiego Baidu skupiającego się początkowo na przetwarzaniu języka mandaryńskiego i przetwarzaniu lokalnych wyników wyszukiwania, 2004 podobną rolę w krajach rosyjskojęzycznych przyjął Yandex.

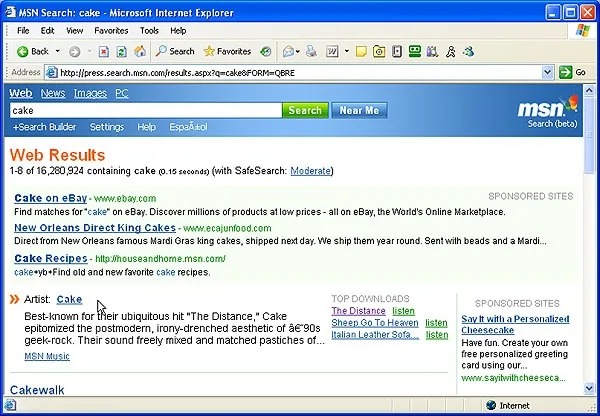

MSN Search jako odpowiedź Microsoftu na działania Google zapoczątkowało powstanie Bing

2009 rok to początek wyszukiwarki Bing, która określana jest następcą MSN Search i Windows Live Search od firmy Microsoft, a w 2010 powstała pierwsza wyszukiwarka skupiająca się głównie na prywatności użytkowników i było nią DuckDuckGo. W związku z nałożonymi w 2019 roku przez Stany Zjednoczone sankcjami, firma Huawei utraciła dostęp do usług Google na swoich urządzeniach. W celu obejścia niedogodności spowodowanych brakiem możliwości korzystania z wyszukiwarki Google, chiński producent elektroniki użytkowej rozwinął własne narzędzie o nazwie Petal (tł. płatek).

Jak działają wyszukiwarki internetowe?

Z pozycji zwykłego użytkownika, po wpisaniu pożądanego zagadnienia w wyszukiwarce, pojawiają nam się wyniki wyszukiwania. Ot filozofia działania. Rzeczywistość jest jednak dużo bardziej skomplikowana.

Wyszukiwarka internetowa stara się wyświetlić takie wyniki wyszukiwania, które najbardziej odpowiadają naszemu zapytaniu i spełniają intencję tego zapytania. Proces przygotowania takiej odpowiedzi składa się z trzech głównych etapów i zaczyna się dużo wcześniej przed wpisaniem poszukiwanej przez nas frazy w oknie Szukaj.

Crawling – przeszukiwanie sieci i zbieranie danych

Pierwszym etapem przygotowania wyszukiwarki pod odpowiedzi na nasze pytania jest przeszukanie sieci i zebranie danych o stronach internetowych publicznie dostępnych. Dzieje się tak, ponieważ narzędzia te wykorzystują boty (lub jak to społeczność SEO fachowo nazywa crawlery), które przemierzając Internet od strony do strony, zbierają informacje o odwiedzonych treściach.

Głównym zadaniem crawlerów jest:

- Podążanie za linkami – roboty internetowe przeskakują ze strony na stronę za pomocą linków na nich umieszczonych. W przypadku linków wewnętrznych bot przechodzi z jednej podstrony do drugiej w obrębie tej samej witryny, dzięki linkom zewnętrznym opuszcza naszą domenę.

- Analiza zawartości – roboty indeksujące przeszukują kod HTML wygenerowanej strony w poszukiwaniu informacji oraz zwracają uwagę na takie elementy jak tekst, obrazy, nagłówki, metaopisy czy struktura linków.

- Wykrywanie aktualizacji: crawlery kilkukrotnie odwiedzają daną podstronę, analizując czy dokonane zostały na niej zmiany istotne pod kątem potencjalnych wyników wyszukiwania.

Indexing – organizowanie informacji

Wszystkie zebrane przez roboty crawlujące informacje, przechowywane są w ogromnej bazie danych zwanej indeksem. Jest to pewnego rodzaju katalog zawierający miliardy stron internetowych, które są uporządkowane tak, aby umożliwić szybkie przeszukiwanie danych. Możliwe jest to dzięki odpowiednim procesom zachodzącym już na etapie indeksacji pozyskanych zasobów:

- Porządkowanie treści -zebrane informacje ze strony są na początku analizowane, a później odpowiednio skatalogowane na podstawie tematyki, słów kluczowych, czy struktury strony.

- Analiza treści pod kątem przydatności – treści zduplikowane, uszkodzone strony, czy strony, które potencjalnie mają niską wartość są zazwyczaj odrzucane przez indekser lub ich rola jest marginalizowana.

- Tworzenie relacji pomiędzy stronami – algorytmy zapisują powiązania pomiędzy stronami poprzez analizę linków wewnętrznych i zewnętrznych, co pomaga w ocenie ich ważności.

Ranking i algorytmy wyszukiwania

W momencie, gdy użytkownik wpisze zapytanie w polu wyszukiwarki, czy to będzie zwykłe słowo kluczowe, czy konkretne pytanie, uruchamiany jest proces analizy indeksu w celu znalezienia najbardziej trafnych wyników. W ogólnym uproszczeniu możemy przyjąć, że wyświetlenie poszczególnych wyników podzielone jest na etapy:

Dopasowanie zapytania do indeksu

- Analiza słów kluczowych – algorytmy odpowiedzialne za dopasowanie intencji użytkownika do odpowiedzi jaką powinien uzyskać, analizują wpisane słowa oraz poszukują ich występowania w zaindeksowanych stronach.

- Synonimy – algorytmy te odpowiadają również za rozpoznanie i odpowiedni dobór synonimów, podobnych fraz oraz intencji użytkownika na przykład, czy zapytanie dotyczy zakupu, lokalizacji, czy jest pytaniem o konkretną definicję.

Dobór odpowiednich stron – analiza rankingu

Mając wszystkie potrzebne informacje, czyli katalog serwisów oraz pytanie od użytkownika wyszukiwarka za pomocą wbudowanych algorytmów przygotowuje wyniki. Nie od dzisiaj wiadomo, że algorytmy serwisu pomagają w stworzeniu rankingu w celu określenia, które strony mogą być bardziej przydatne dla użytkownika, a które nie. Żaden z autorów wyszukiwarki nie przyzna się, co dokładnie wpływa na to, że jedne strony pojawiają się wyżej w wynikach wyszukiwania, a inne niżej, jednakże można zaobserwować wiele powtarzających się wzorców:

- Trafność treści – element ten odpowiada za to, czy zawartość strony w ogóle odpowiada zapytaniu użytkownika np. na pytanie o mechanika samochodowego, czy strona faktycznie zawiera informacje o mechaniku, a nie o kosmetykach.

- Jakość strony – algorytmy weryfikują jakość serwisu na podstawie unikalności treści, weryfikacji, czy treści są aktualne i użyteczne.

- Popularność strony – odpowiednie algorytmy weryfikują, czy strona, która ma zostać wyświetlona, jest popularna tj. czy inne serwisy o niej mówią np. za pomocą zewnętrznych linków przychodzących.

- Lokalizacja – odpowiada m.in. za wyświetlanie wyników regionalnych. Zależy nam w końcu, aby wyszukując np. restaurację w Warszawie otrzymać wyniki ukierunkowane na stolicę, a nie Poznań.

- Doświadczenie użytkownika – wpływ na to, czy strona będzie wyżej w wynikach wyszukiwania, czy niżej może mieć również to, czy np. strona szybko się ładuje, czy nie ma przeszkadzających odczytujących się elementów powodujących, że strona sama się przewija oraz czy jest dostosowana do przeglądania za pomocą smartfona, czy tableta.

Prezentacja wyników

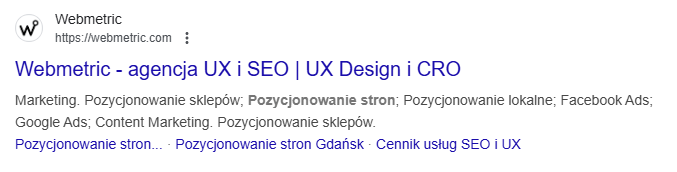

Mając na uwadze powyższe przykłady oraz wiele innych czynników i algorytmów, wyszukiwarka przygotowuje listę wyników, którą wyświetla na stronie pieszczotliwie zwanej SERP (od Search Engine Results Page).

Na przykładzie wyszukiwarki Google, strona taka zawierać może:

- Organiczne wyniki wyszukiwania – są to strony, które na podstawie analizy zapytania przez algorytmy, najbardziej odpowiadają pytaniu i intencjom użytkownika.

- Reklamy – często oznaczone jako wyniki sponsorowane, są to płatne reklamy, które wyświetlają się dzięki osiągnięciu dobrych wyników w aukcji. W dużym skrócie działa to tak, że firma, która da więcej za wyświetlenie danego słowa kluczowego, ma szansę wygrać wyższe miejsce w sekcji reklam.

- Elementy rozszerzone – bardzo często do wyników wyszukiwania oprócz wyników płatnych i organicznych dołączone są elementy dodatkowe np. mapki z lokalizacją, grafy wiedzy, czy prezentacja produktów z linkiem do sklepu.

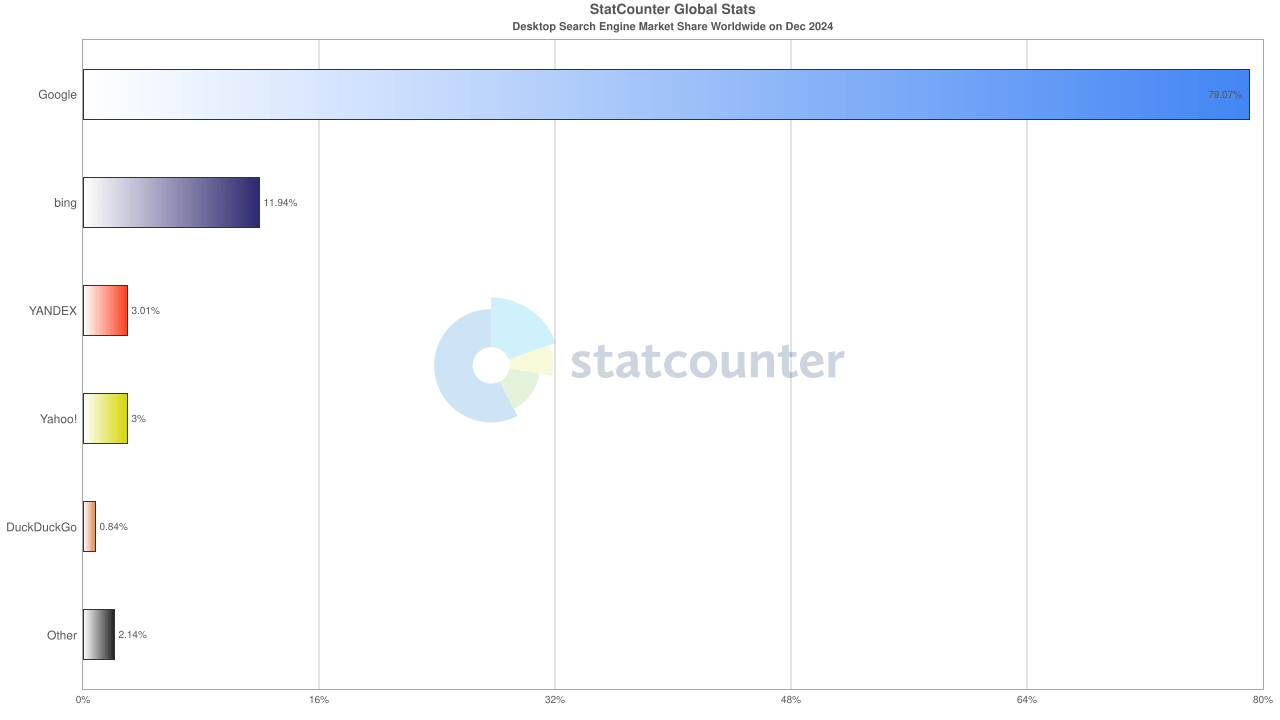

Najpopularniejsze wyszukiwarki internetowe w 2025 roku

Aktualnie Google jest najpopularniejszą wyszukiwarką internetową dostępną w Internecie. Rok 2024 zakończyła na poziomie 79,09% udziału na rynku wyszukiwarek internetowych na komputerach stacjonarnych na całym świecie. Drugi Bing posiada 11,94% światowego rynku. Kolejny w zestawieniu jest Yandex (3,01%), Yahoo! (3%), DuckDuckGo (0,84%) oraz Baidu (0,77%).

Porównując powyższe z analogiczną końcówką 2023 roku można zauważyć niewielki spadek popularności Google (81,71%) na rzecz swoich konkurentów.

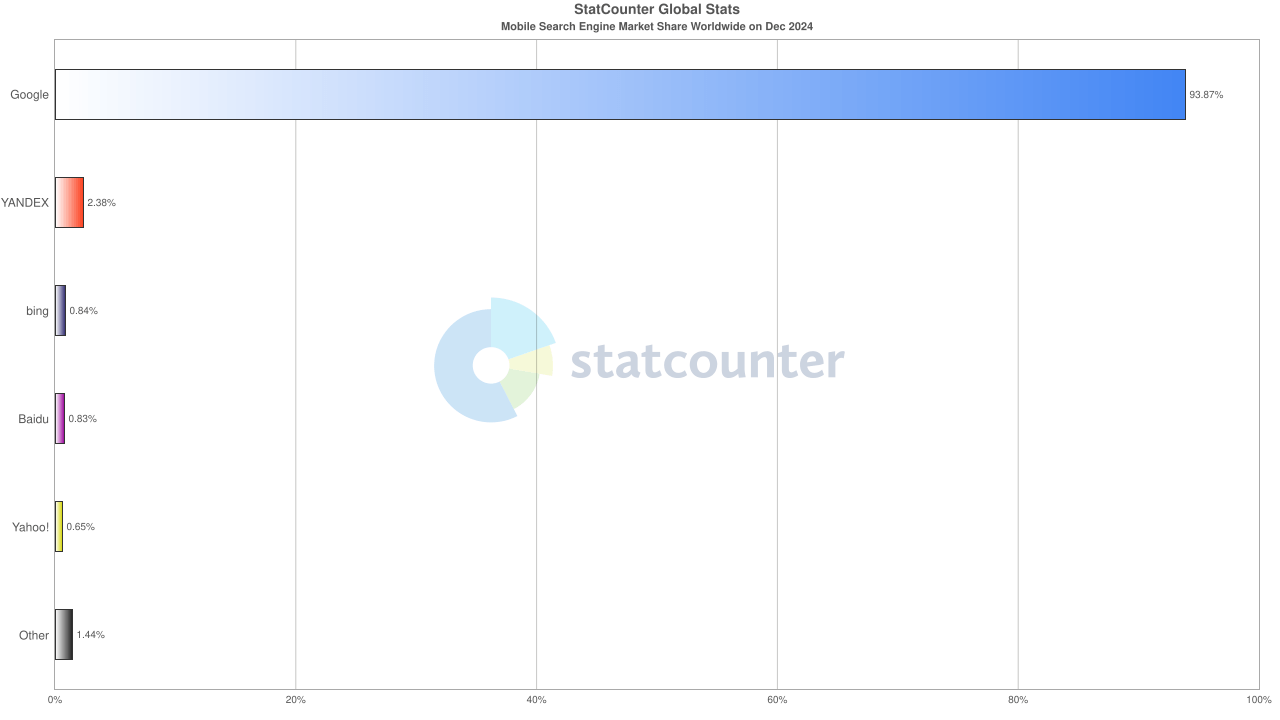

Google bezkonkurencyjne na urządzeniach mobilnych

Na światowym rynku urządzeń mobilnych, Google prezentuje się jeszcze mocniej. Na koniec 2024 roku, wyszukiwarka giganta z Redmond przejęła 93,87% rynku (dla porównania: Yandex 2,38%, Bing 0,84%, Baidu 0,83%, a Yahoo! 0,65%). O ile kwestia lidera pozostaje tutaj bez zmian, o tyle widać, że na drugim miejscu jest wyszukiwarka z Rosji, a popularność Binga, czy Yandexa nie mieści się nawet w 1%.

Popularność Google w Polsce

W przypadku popularności wyszukiwarek internetowych nad Wisłą wpisujemy się w światowy trend, gdzie Google posiada ponad 91,88% krajowego rynku. Nadal drugą najpopularniejszą wyszukiwarką jest Bing (5,19%). Za ciekawostkę dotyczącą wyszukiwarek w Polsce można uznać fakt, iż na 6 miejscu popularności (na poziomie 0.08%), po Google, Bingu, Yandexie, DuckDuckGo i Yahoo! jest mało znana, francuska wyszukiwarka ukierunkowana na anonimowość danych o nazwie Qwant.

Gdzie Google nie jest liderem

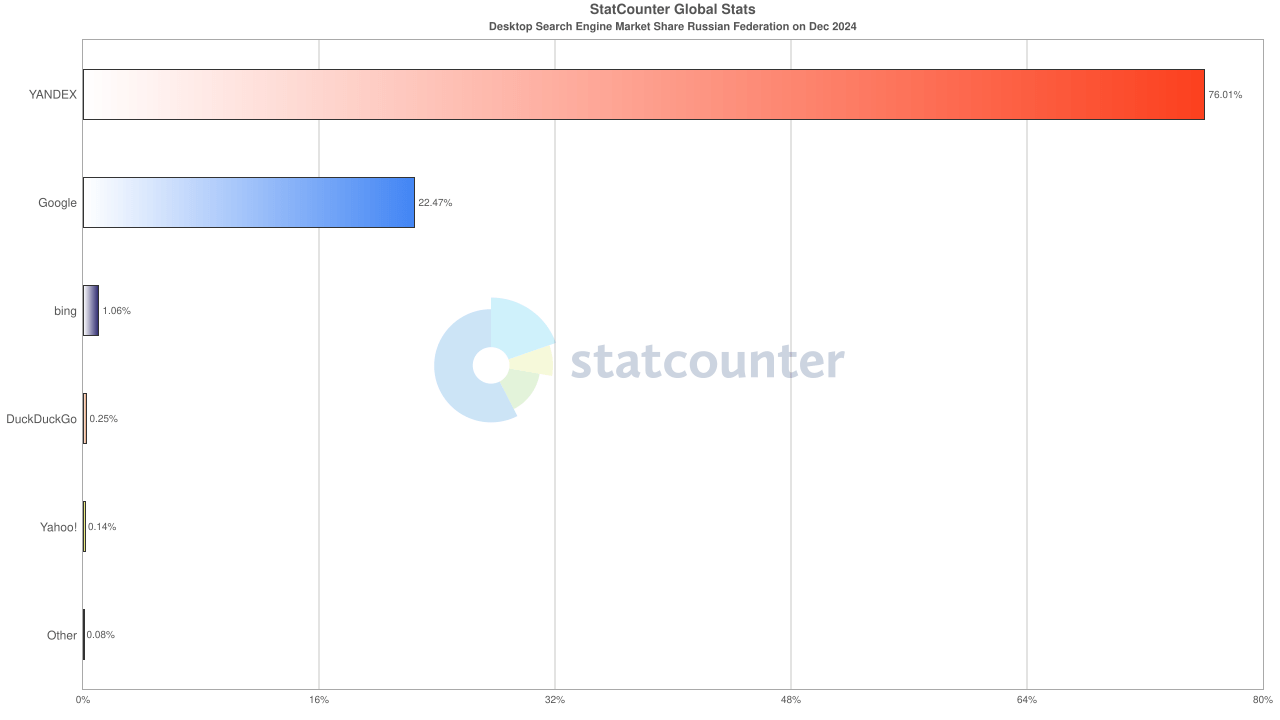

Są na świecie kraje, gdzie Google nie jest liderem jeżeli chodzi o wyszukiwarki. Mowa tutaj głównie o Federacji Rosyjskiej oraz Chinach. Oba kraje celowo blokują dostęp do zachodnich technologii, aby móc bardziej kontrolować swoich mieszkańców.

W Chinach najpopularniejszą wyszukiwarką jest Baudu (45%). Na drugim miejscu jest Bing (37,74%), a dalej mamy Haosou (8%), Yandex (3%) oraz Sogu (2,64%).

W Rosji natomiast można zaobserwować, że głównym narzędziem do wyszukiwania informacji w Internecie jest Yandex (74,41%). Co ciekawe Goole, mimo sankcji i ograniczonego dostępu, przejmuje ponad 24% krajowego rynku.

Algorytmy wyszukiwarek

Każdy, kto miał styczność zarówno z Agencją SEO, jak i freelancerem pozycjonującym jego stronę, kiedy obserwował nagłe znaczne spadki widoczności serwisu, mógł spotkać się ze stwierdzeniem: Nastąpiła aktualizacja algorytmu, przez co spadły pozycje. W celu zrozumienia istoty tego zjawiska należy odpowiedzieć sobie na podstawowe pytanie:

Czym jest algorytm wyszukiwarki?

Algorytm wyszukiwarki internetowej to serce każdej wyszukiwarki. Jego zadaniem jest dostarczenie użytkownikowi najlepszych i najbardziej trafnych wyników wyszukiwania w jak najkrótszym czasie. Same algorytmy to bardzo zaawansowane programy, wykorzystujące m.in. przetworzone zapytania użytkowników, analizowane dane o odwiedzonych stronach, które prezentują dane o wiele czynników rankingowych.

Przykładowe algorytmy Google

- PageRank – pierwszy algorytm stworzony przez założycieli Google w 1998 roku. Odpowiadał za ocenę wartości strony internetowej na podstawie liczby i jakości linków przychodzących. Obecnie, oficjalnie, ten algorytm nie jest już wykorzystywany do oceny wartości strony.

- Panda (2011) – algorytm odpowiedzialny za selekcjonowanie stron o niskiej wartości tj. strony zawierające spam, czy kopiujące treści z innych serwisów. Do analizy wykorzystuje m.in takie czynniki jak unikalność treści, czas spędzony na stronie oraz współczynnik odrzuceń.

- Pingwin (2012) – algorytm walczący z nienaturalnym linkowaniem. Od jego uruchomienia, wszystkie spam-linki przestały mieć pozytywne znaczenie dla serwisu. Do kluczowych czynników zaliczyć możemy: jakość linków przychodzących oraz zróżnicowanie linków (w tym anchor tekstów).

- Koliber (2013) – wspiera zrozumienie zapytań użytkowników pod kątem long-tail keywords, czyli słów kluczowych z dłuższym ogonem. Dzięki niemu, wyszukiwarka bardziej rozumie intencje użytkownika.

- Gołąb (2014) – poprawia jakość lokalnych wyników wyszukiwania. Wpływ na lepsze rozumienie strony przez ten algorytm mają m.in. wizytówki Google Moja Firma.

- Mobile-Friendly Update (2015) – promowanie stron dostosowanych do urządzeń mobilnych.

- June 2024 Spam Update – jedna z ważniejszych aktualizacji algorytmy jaka odbyła się w 2024 roku. Zmiany miały na celu ograniczenie widoczności serwisów, których treści uznać można za spam i nieprzydatne dla użytkowników. W dużej części chodziło również o ograniczenie serwisów, które generują duże ilości treści za pomocą sztucznej inteligencji, nie weryfikując tekstów, które są później publikowane.

Jest to niewielki zakres algorytmów Google, które wspomagają wyświetlanie najbardziej odpowiednich wyników wyszukiwania. Należy zaznaczyć, że raz wydany algorytm nie jest pozostawiany sam sobie. Często jest aktualizowany, przez co raz dostosowanie strony może być niewystarczające i z czasem wymagana będzie reoptymalizacja.

Przykładowe algorytmy Bing

Nie tylko Google słynie ze swoich algorytmów. Inne wyszukiwarki internetowe również opierają swoje wyniki wyszukiwania o autorskie narzędzia analizujące zapytania, intencje i zawartość stron.

- SPTAG (Space Partition Tree And Graph) – algorytm oparty o uczenie maszynowe wykorzystywany do wyszukiwania informacji w dużych zbiorach danych. Pozwala Bingowi na lepsze zrozumienie złożonych zapytań oraz zapewnienie wyników kontekstowych.

- RankNet – algorytm oparty o sieci neuronowe odpowiedzialny za ocenę i ranking stron w wynikach wyszukiwania. Jest jednym z kluczowych elementów technologii rankingowej Bing.

- Click Signals Algorithm – algorytm wykorzystujący interakcje użytkowników z wynikami wyszukiwania. Pomaga dostosować Bingowi wyniki do rzeczywistych preferencji użytkownika.

- Image Search Algorithm – specjalny algorytm do przeszukiwania obrazów oparty o technologię rozpoznawania obrazów. Czyni to z Binga jedno z lepszych rozwiązań do dokładnego wyszukiwania wyników za pomocą obrazu.

Przykładowe algorytmy Yandex

Yandex jako wyszukiwarka działa od 1997 roku. Od 2008 wprowadzony został algorytm Magadan, który zapoczątkował tradycję nadawania nazw algorytmom od nazw miast.

- Krasnodar (2010) – wspomaga rozwój technologii wyszukiwania poprawiając trafność wyników

- Reykjavik (2011) – wspomaga zrozumienie zapytań w językach obcych

- Kaliningrad (2012) – poprawia analizę semantyczną i rozumienie kontekstu zapytań

- Dublin (2013) – wspomaga analizę treści i jakość wyników wyszukiwania.

Jak pozycjonowanie wpływa na wyniki wyszukiwarek

Pozycjonowanie ma na celu wpłynięcie tak na wyniki wyszukiwania, aby nasza strona znalazła się wyżej w SERPach. Działania te opierają się na:

- Optymalizacja SEO – działania opierające się na dostosowaniu kodu strony, aby była ona bardziej zrozumiała dla robotów indeksujących

- Tworzenie treści – przygotowanie i tworzenie treści przyjaznych użytkownikom, spełniającym ich intencje, które są wysokiej jakości.

- Link building – pozyskiwanie wartościowych linków przychodzących

W zależności od stosowanej techniki nasze działania możemy podzielić na:

- etyczne pozycjonowanie (tzw. white hat SEO) polegające na działaniach zgodnych z wytycznymi wyszukiwarek. Działania te nastawione są na długoterminowe budowanie widoczności, brak możliwości dostania kary oraz zwiększenie wiarygodności i zaufania użytkownika.

- nieetyczne pozycjonowanie (tzw. black hat SEO) polegające na wykorzystywaniu technik niezgodnych z wytycznymi wyszukiwarek. Działania te szybko wpływają na zwiększenie widoczności serwisu, jednakże mogą przynieść negatywne konsekwencje w postaci kar ręcznych, filtrów algorytmicznych czy całkowitego usunięcia serwisu z indeksu.

- pośrednie pozycjonowanie (grey hat SEO) jest rozwiązaniem balansującym pomiędzy poprzednimi dwoma technikami. Pozwala osiągnięcie wymiernych wyników w krótszym czasie niż przy stosowaniu WHS. Ponadto opiera się również na pozyskiwaniu wartościowych linków zwrotnych co wpisuje się w metody BHS.

W zależności od rodzaju działań i techniki, jaką stosujemy możemy wpłynąć na to jak nasza strona będzie odbierana przez wyszukiwarki internetowe. Pozycjonując serwis, musimy jednak wziąć pod uwagę jeszcze 2 główne aspekty:

- Prawdopodobnie nie tylko my pozycjonujemy swój serwis na dane słowo kluczowe, więc nasze działania to nie tylko walka z algorytmami wyszukiwarki, ale również z działaniami konkurencji.

- Wyszukiwarki internetowe aktualizują swoje algorytmy, więc raz przeprowadzone działania w danym obszarze po czasie mogą być niewystarczające. Zmiany te mogą być kosmetyczne jak np. wprowadzenie Core Web Vitals, które miało być radykalną zmianą w kontekście układania rankingu stron w wyszukiwarkach Google co ostatecznie nie wpłynęło tak drastycznie na SERPy jak to było zapowiadane. Na drugim biegunie natomiast jest wprowadzenie algorytmu Pingwin, który spowodował, że ze względu na istniejący przed 2012 rokiem spam linków, wiele serwisów bezpowrotnie straciło swoją pozycję w rankingu, a część z nich wręcz została stale wyindeksowana.

Czy AI zastąpi wyszukiwarki internetowe?

Wraz z rozwojem AI pojawia się pytanie, czy giganci tacy jak Google czy Microsoft powinni obawiać się przyszłości. Moim zdaniem – tak. Internet zmienia się, a my jako użytkownicy chętnie podążamy za nowinkami, które wpływają na sposób, w jaki docieramy do informacji. Jako osoba zajmująca się stronami internetowymi, wiem, ile pracy wymaga dostosowanie witryny do wytycznych Google. Tworzę wartościowe treści, zdobywam linki przychodzące, dbam o autorytet strony – wszystko po to, aby potencjalny klient znalazł moją ofertę.

Ale co, jeśli w przyszłości wyszukiwarki nie będą już działać tak jak teraz? Jeśli moja strona nie będzie już „celem” dla użytkownika, ale jedynie źródłem informacji dla AI? Obecne trendy pokazują, że wyszukiwarki coraz częściej stają się „pokazywarkami”. Użytkownik nie musi klikać w linki – wszystko ma podane na tacy. To rewolucja, która może zmienić sposób, w jaki tworzymy i odbieramy treści online.

Bing, Gemini i nowe nawyki użytkowników

AI już teraz wpływa na nasze codzienne nawyki. Zamiast przeszukiwać dziesiątki stron, wolimy szybkie, gotowe odpowiedzi. Kiedy Chat GPT pojawił się na rynku, wielu z nas przekonało się, że jedno pytanie do AI może zastąpić wizytę na kilku witrynach. Microsoft wprowadził model AI do Binga, który na bieżąco analizuje dane, oferując aktualne odpowiedzi. Google odpowiedział Gemini – rozwiązaniem, które skupia się na analizie i przedstawianiu wiarygodnych informacji.

Mimo różnic oba narzędzia zmieniają sposób, w jaki podchodzimy do wyszukiwania. Bing i Gemini ułatwiają życie, eliminując konieczność klikania w wiele linków. Ale czy to oznacza, że tradycyjne wyszukiwarki przestaną istnieć? Moim zdaniem, jesteśmy na etapie, w którym AI zaczyna zmieniać zasady gry, ale wciąż mamy przed sobą wiele wyzwań, takich jak unikanie błędów w danych czy halucynacji AI.

Przyszłość wyszukiwarek i stron internetowych

Rozwój sztucznej inteligencji wskazuje, że przyszłość wyszukiwarek internetowych będzie ściśle związana z AI, która coraz częściej zastępuje tradycyjny model wyszukiwania. Narzędzia takie jak Bing i Gemini zmieniają sposób, w jaki uzyskujemy informacje, dostarczając użytkownikowi gotowe odpowiedzi bez konieczności przeszukiwania stron. To oznacza, że witryny mogą stać się bardziej funkcjonalne niż wizualne, pełniąc rolę źródeł danych dla AI. Jednocześnie od nas, twórców treści, zależy jakość materiałów, na których opiera się AI, co wymaga odpowiedzialności i precyzji w ich tworzeniu. Problemy takie jak „halucynacje” AI czy brak regulacji prawnych dotyczących treści generowanych przez sztuczną inteligencję rodzą wyzwania, które mogą wpłynąć na wiarygodność informacji. Przyszłość wyszukiwarek to również konieczność krytycznej oceny tego, co otrzymujemy od AI, oraz dbałość o transparentność i rzetelność w dostarczaniu treści.

- Co to jest wyszukiwarka internetowa?

- Historia wyszukiwarek internetowych

- Jak działają wyszukiwarki internetowe?

- Crawling – przeszukiwanie sieci i zbieranie danych

- Indexing – organizowanie informacji

- Ranking i algorytmy wyszukiwania

- Dopasowanie zapytania do indeksu

- Dobór odpowiednich stron – analiza rankingu

- Prezentacja wyników

- Najpopularniejsze wyszukiwarki internetowe w 2025 roku

- Google bezkonkurencyjne na urządzeniach mobilnych

- Popularność Google w Polsce

- Gdzie Google nie jest liderem

- Algorytmy wyszukiwarek

- Czym jest algorytm wyszukiwarki?

- Przykładowe algorytmy Google

- Przykładowe algorytmy Bing

- Przykładowe algorytmy Yandex

- Jak pozycjonowanie wpływa na wyniki wyszukiwarek

- Czy AI zastąpi wyszukiwarki internetowe?

- Bing, Gemini i nowe nawyki użytkowników

- Przyszłość wyszukiwarek i stron internetowych

![Algorytmy Google – rodzaje i działanie [2026]](https://webmetric.com/wp-content/uploads/2025/11/algorytmy-google.jpg)